Lumarの詳細設定にあるrobots上書き機能を使用すると、プライマリドメイン上のrobots.txtとは異なるバージョンのrobots.txtを使用してサイトをクロールすることができます。

これには主に2つの用途があります。

- 大規模サイトないしは複雑な構造を持つサイト、またはその両方の本番環境用のrobots.txtファイルを作成する

この記事では、robots.txtファイルの上書きを行う利点やそれにより解決できる問題、そして上書き機能の使用方法についてご紹介します。

robots.txtファイルの上書きをウェブクローラーで行う利点

サイト全体での変更の影響を把握する

Googleのrobots.txtテスターツールとは対象的に、ウェブクローラーのrobots.txtの上書き機能を使用すると、それがライブ環境・ステージング環境にかかわらず、既存の1つのURL上だけでなくサイト全体での変更の影響を把握することができます。

クロールされる可能性のある新しいページを確認する

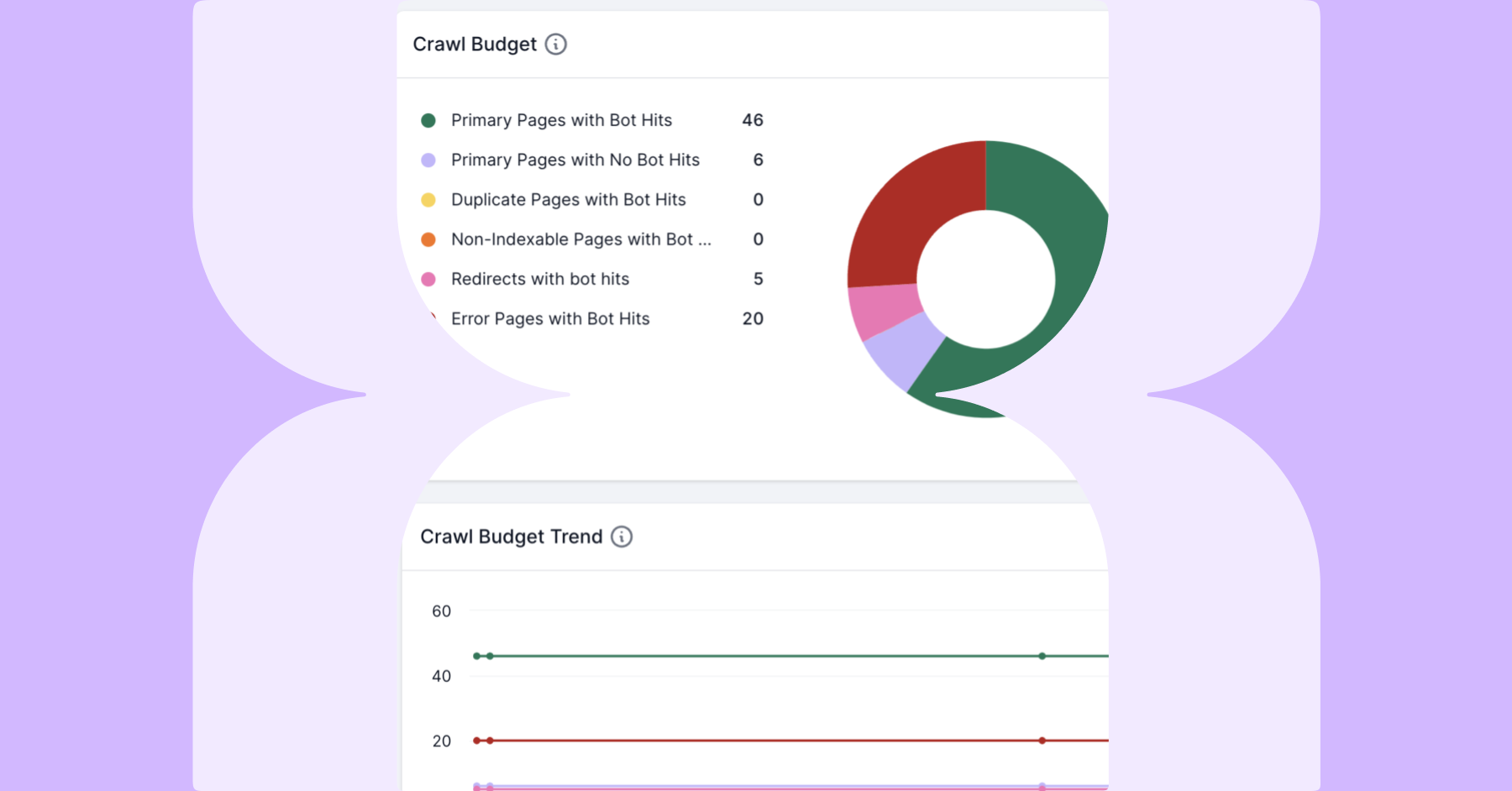

制限が少ないrobots.txtファイルを使用すると、検索エンジンは非常に多くの新しいページ検出することができるため、こうした新しいページのうちどれがクロールされるのか確認できるということになります。これはフルクロールを行なった場合にのみ可能となります。

変更により影響を受けるページを正確に把握する

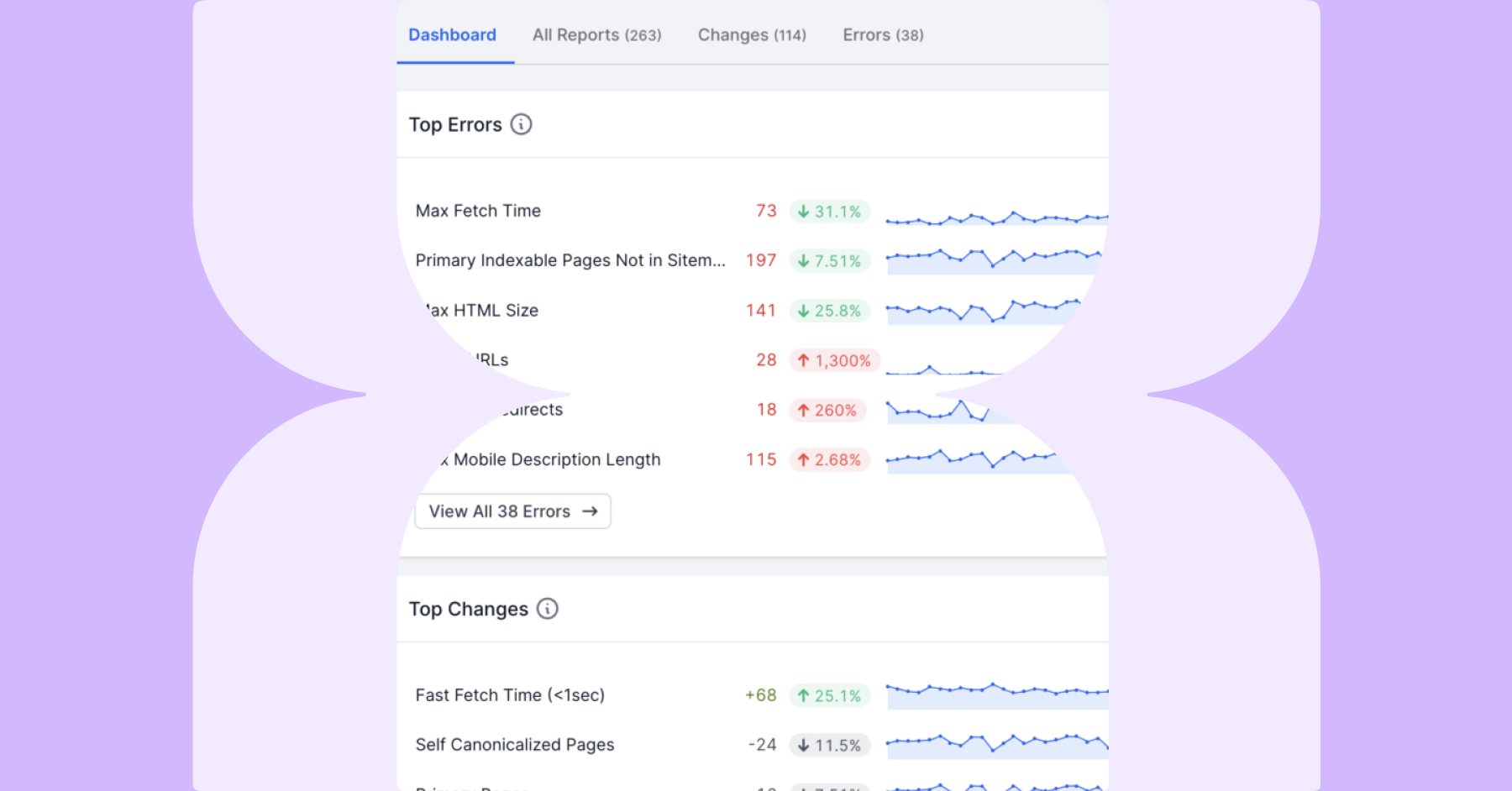

Lumarに搭載されたrobots.txtの上書き機能を使用してクロールすると、変更されたrobots.txtの影響を受けるURLがLumarのレポートで正確に把握できるようになり、変更後のURL評価が非常に簡単になります。

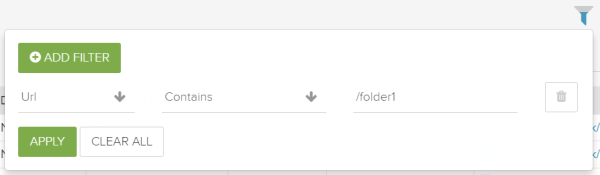

分析をより簡単に行うため、レポートのフィルタリングを行うことができます。これにより、特にパラメータが存在する場合や細々したURLが含まれる場合には、パターンの把握と長いURLリストの中から容易に探し出せないQuick Winの優先順位付けが簡易化できます。

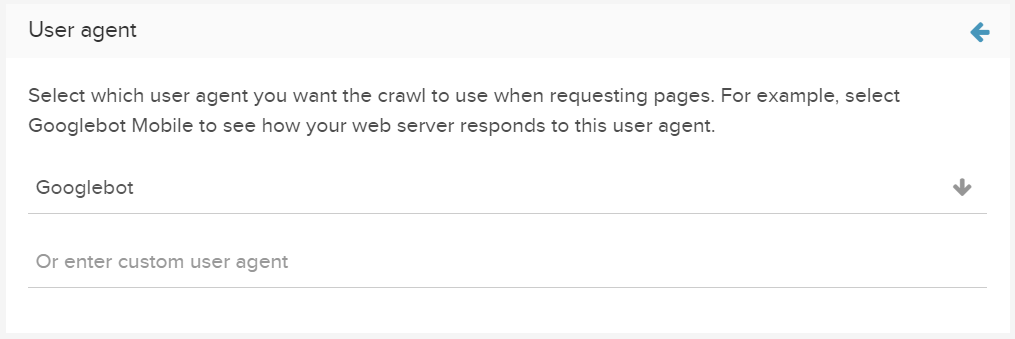

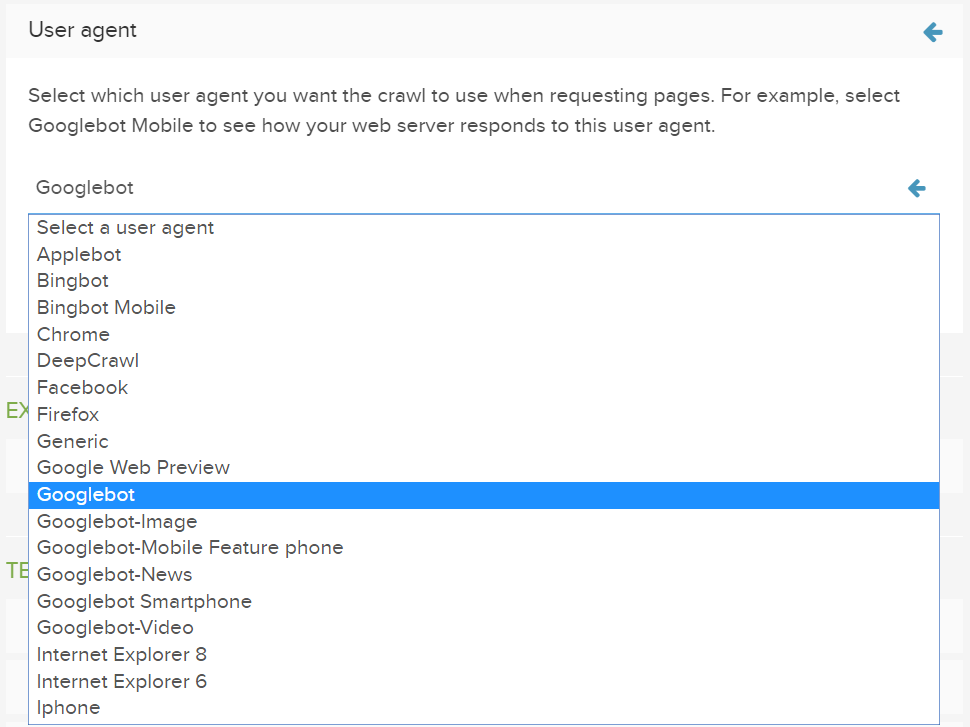

異なるユーザーエージェントでテストを実施する

ウェブクローラーを使えば同じツール内でGooglebot、Bingbot、その他さまざまなユーザーエージェントを使用してrobots.txtファイルのテストが可能になるため、それぞれの検索エンジンのサイトクロール方法の違いを把握できます。

事例1:大規模サイトないしは複雑な構造を持つサイト向けの本番用robots.txtを開発する

問題点:

サイト構造における変更点を反映するため、またサイトのクロール効率を上げるためにrobots.txtファイルを定期的に更新する必要があります。間違ってdisallowとなってしまったり、価値がないにもかかわらずクロールバジェットを浪費したりしてしまう問題がすでに存在しているかもしれません。

たった1文字でも間違っていればインデックスからサイト全体が削除されかねないという点で、robots.txtに変更を加えることは常にリスクを伴います。

サーチコンソールのrobots.txtテスターを使うことで限られた数のURLを検証する事ができますが、これでは大規模サイトや複雑な構造のサイトにおいてはrobots.txtファイルの変更がもたらす影響を完全に理解することはできません。

解決策:

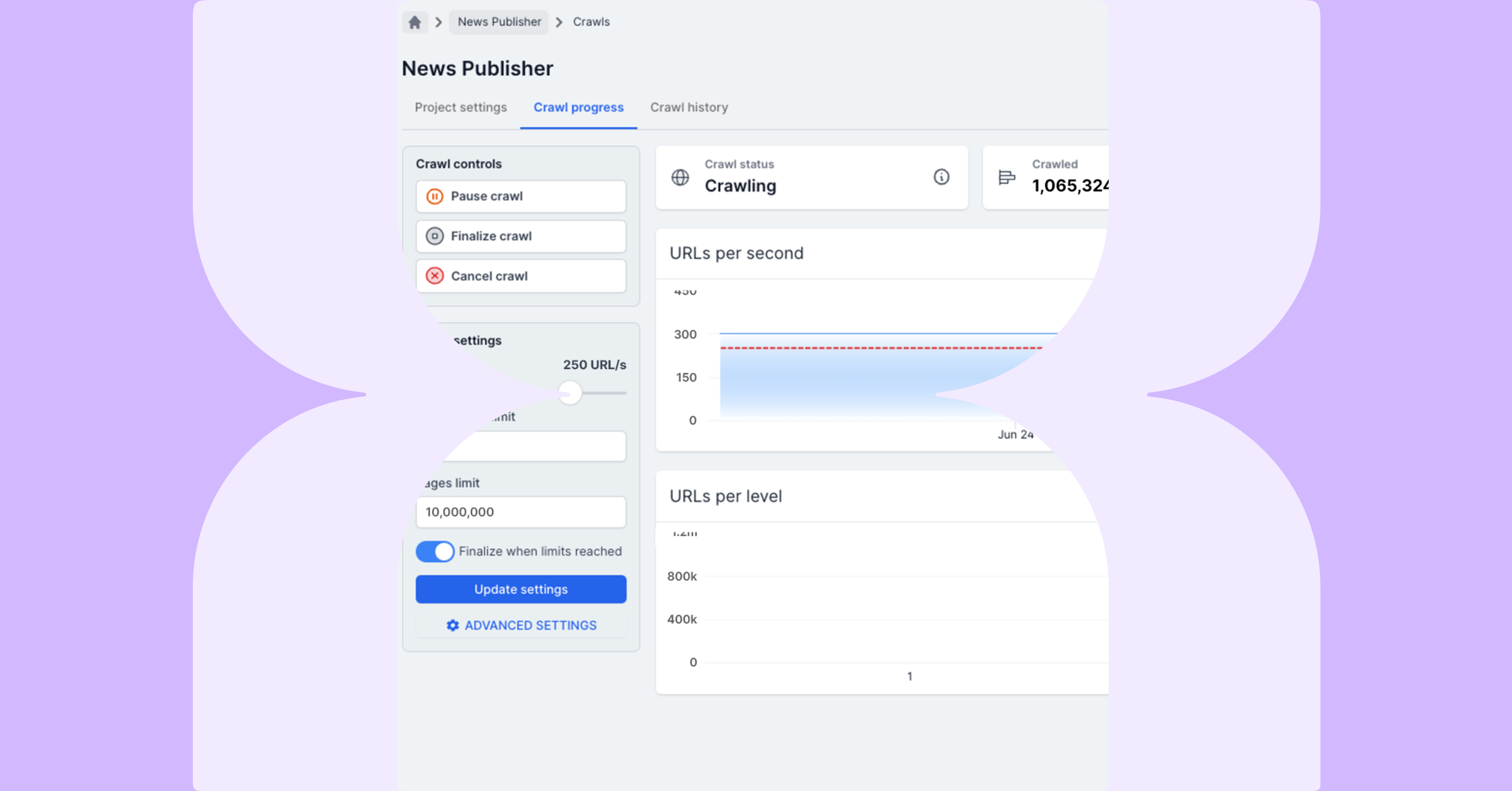

変更済robots.txtを使用してLumarで本番サイトをクロールすると、実際の検索結果でのサイトのインデックスに影響を与えずにこれら変更点の影響を確認でき、実際のパフォーマンスに影響を及ぼす前に問題点を修正することができます。

具体的な手順:

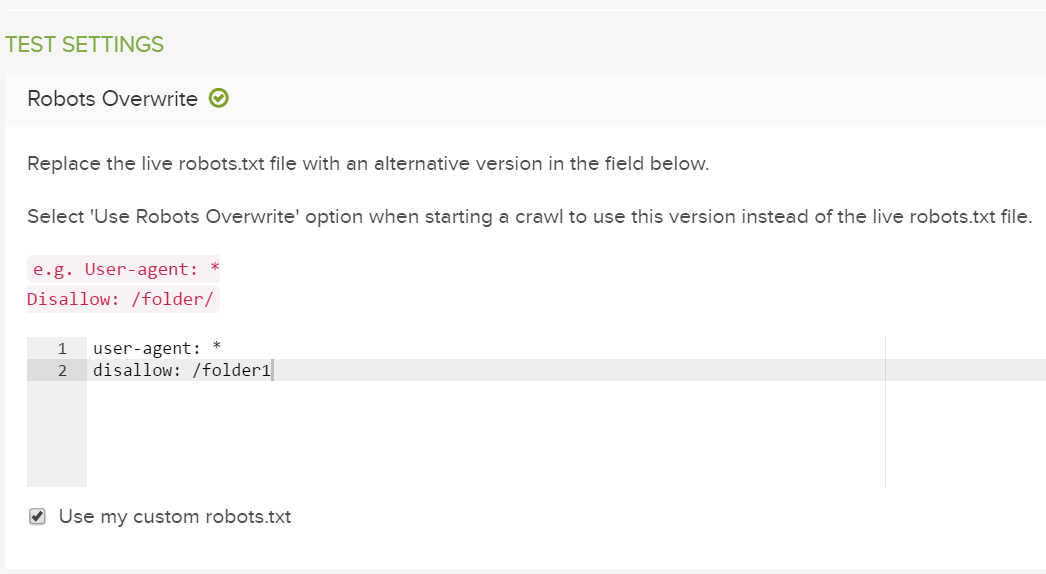

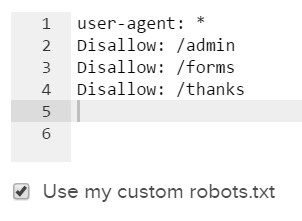

1.詳細設定の[robotsの上書き]に修正済のrobots.txtファイルを追加し、クロールを実行する前にカスタムrobots.txtを使用するというチェックボックスを選択してください。

2.その後、このrobots.txtの修正によって、どのURLが許可されるようになったか、許可されなくなったかを確認してください。

結果が満足行くものであれば、更新済robots.txtを本番へ反映し、次のクロールの前にはカスタムrobots.txtを使用するというチェックを外して、本番用のrobots.txtファイルでクロールを開始してください。

事例2:disallow設定のあるステージングサイトのクロール

問題点:

ドメインのrobots.txtファイルで全てのステージングURLがdisallowでブロックされていると、ステージングサイトが検索エンジンからインデックスされなくなることが頻繁に発生します。しかし、インデックスに関する問題を確認するためにステージングサイトをクロールする際には、この設定では問題が発生します。つまり、本番サイトのrobots.txtファイルがステージングサイトのrobots.txtと完全に異なるために、間違った結果を発生させてしまうのです。disallowのあるページからリンクされたページはクロールの対象にもなりません。

解決策:

変更点を本番に反映する前にステージングサイトをクロールする際、ステージングサイトのrobots.txtファイルを変更して本番サイトにその設定を反映する方法が必要となります。

Lumarのrobots.txtの上書き機能を使えば、この変更は非常に簡単となり、ステージングサイトをあたかも本番サイトのようにクロールすることができます。

具体的な手順:

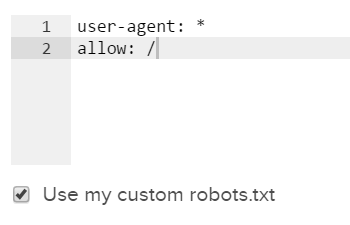

1.本番サイト用のrobots.txtをコピーするか、またはrobots.txtの一般的な全てを許可する設定を詳細設定のrobotsの上書き機能に入力してください。カスタムrobots.txtファイルを使う設定にチェックを入れるようにしてください。

2.任意のユーザーエージェントを設定して、通常のユニバーサルクロール設定を進めてください。